ثلاثة اجزاء بوسنية نص. ثلاثة عشر جزء كردي. خمسة وخمسون أجزاء السواحيلية. أحد عشر ألف جزء باللغة الإنجليزية.

هذا جزء من وصفة البيانات لنموذج اللغة الكبيرة الجديد على Facebook ، والذي تدعي الشركة أنه قادر على اكتشاف وكبح المحتوى الضار بأكثر من 100 لغة. يستخدم Bumble تقنية مشابهة لاكتشاف الرسائل الوقحة وغير المرغوب فيها بـ 15 لغة على الأقل. تستخدمه Google في كل شيء بدءًا من الترجمة وحتى تصفية أقسام التعليقات في الصحف. تحتوي جميعها على وصفات قابلة للمقارنة ونفس المكون السائد: بيانات باللغة الإنجليزية.

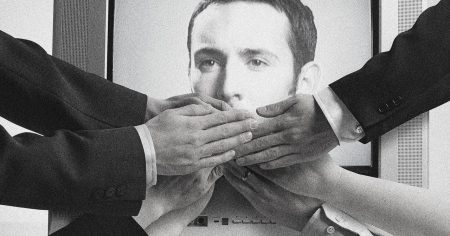

لسنوات ، ركزت شركات وسائل التواصل الاجتماعي جهود الكشف التلقائي عن المحتوى وإزالته على المحتوى باللغة الإنجليزية أكثر من 7000 لغة أخرى في العالم. ترك Facebook ما يقرب من 70 في المائة من المعلومات المضللة المتعلقة بفيروس كوفيد باللغتين الإيطالية والإسبانية دون تمييز ، مقارنة بـ 29 في المائة فقط من المعلومات المضللة المشابهة باللغة الإنجليزية. تكشف الوثائق المسربة أن المنشورات باللغة العربية يتم تمييزها بشكل خاطئ على أنها كلام يحض على الكراهية. ساهم ضعف الاعتدال في محتوى اللغة المحلية في انتهاكات حقوق الإنسان ، بما في ذلك الإبادة الجماعية في ميانمار ، والعنف العرقي في إثيوبيا ، والمعلومات المضللة عن الانتخابات في البرازيل. على نطاق واسع ، فإن قرارات استضافة المحتوى أو تخفيضه أو إزالته تؤثر بشكل مباشر على الحقوق الأساسية للأشخاص ، لا سيما حقوق الأشخاص المهمشين الذين لا يملكون سوى القليل من السبل الأخرى للتنظيم أو التحدث بحرية.

تكمن المشكلة في جزء منها في الإرادة السياسية ، لكنها أيضًا تحد تقني. من الصعب بالفعل إنشاء أنظمة يمكنها اكتشاف البريد العشوائي والكلام الذي يحض على الكراهية والمحتويات الأخرى غير المرغوب فيها بجميع لغات العالم. ما يجعل الأمر أكثر صعوبة هو حقيقة أن العديد من اللغات “منخفضة الموارد” ، مما يعني أن لديها القليل من البيانات النصية الرقمية المتاحة لتدريب الأنظمة الآلية. بعض هذه اللغات منخفضة الموارد لديها عدد محدود من المتحدثين ومستخدمي الإنترنت ، لكن البعض الآخر ، مثل الهندية والإندونيسية ، يتحدث بها مئات الملايين من الناس ، مما يضاعف الأضرار التي تسببها الأنظمة الضالة. حتى لو كانت الشركات على استعداد للاستثمار في بناء خوارزميات فردية لكل نوع من أنواع المحتوى الضار في كل لغة ، فقد لا يكون لديها بيانات كافية لجعل هذه الأنظمة تعمل بشكل فعال.

أحدثت تقنية جديدة تسمى “نماذج اللغات الكبيرة متعددة اللغات” تغييرًا جذريًا في كيفية تعامل شركات الوسائط الاجتماعية مع الإشراف على المحتوى. نماذج اللغات المتعددة – كما وصفنا في ورقة جديدة – تشبه GPT-4 ونماذج اللغات الكبيرة الأخرى (LLMs) ، باستثناء أنها تتعلم المزيد من القواعد العامة للغة من خلال التدريب على نصوص بعشرات أو مئات من اللغات المختلفة. وهي مصممة خصيصًا لإجراء اتصالات بين اللغات ، مما يسمح لهم بالاستقراء من تلك اللغات التي لديهم الكثير من بيانات التدريب الخاصة بها ، مثل اللغة الإنجليزية ، للتعامل بشكل أفضل مع تلك التي لديهم بيانات تدريب أقل ، مثل البوسنية.

أثبتت هذه النماذج قدرتها على القيام بمهام دلالية ونحوية بسيطة في نطاق واسع من اللغات ، مثل تحليل القواعد اللغوية وتحليل المشاعر ، ولكن ليس من الواضح مدى قدرتها على القيام بمهمة أكثر تحديدًا تتعلق باللغة والسياق من تنسيق المحتوى ، لا سيما في اللغات التي بالكاد تدربوا عليها. وإلى جانب التدوينة التي تهنئ الذات من حين لآخر ، لم تكشف شركات وسائل التواصل الاجتماعي سوى القليل عن مدى جودة عمل أنظمتها في العالم الحقيقي.

لماذا قد متعدد اللغات تكون النماذج أقل قدرة على تحديد المحتوى الضار مما تقترحه شركات التواصل الاجتماعي؟

أحد الأسباب هو جودة البيانات التي يتدربون عليها ، لا سيما في اللغات منخفضة الموارد. في مجموعات البيانات النصية الكبيرة التي تُستخدم غالبًا لتدريب النماذج متعددة اللغات ، فإن اللغات الأقل تمثيلًا هي أيضًا تلك التي تحتوي في أغلب الأحيان على نص مسيء أو إباحي أو مترجم آليًا أو مجرد رطانة. يحاول المطورون أحيانًا تعويض البيانات الضعيفة عن طريق ملء الفراغ بالنص المترجم آليًا ، ولكن مرة أخرى ، هذا يعني أن النموذج سيظل يواجه صعوبة في فهم اللغة بالطريقة التي يتحدث بها الناس بالفعل. على سبيل المثال ، إذا تم تدريب نموذج لغوي فقط على نص مترجم آليًا من الإنجليزية إلى Cebuano ، وهي لغة يتحدث بها 20 مليون شخص في الفلبين ، فربما لم ير النموذج “kuan” ، وهي لغة عامية يستخدمها المتحدثون الأصليون ولكن واحد لا يحتوي على أي مصطلح مشابه في اللغات الأخرى.